2025年4月10日

エグゼクティブのための生成AI講座 その4 ―作ってみよう、Podcast編(前編)―

シリーズ再開

本シリーズのその1、2、3では、生成AIの中核技術であるLLM(大規模言語モデル)の紹介を行った。そのエッセンスは、①ニューラルネットという1980年代に発展したAI技術が基礎となっていること、②言葉をコンピュータで扱うために、ある単語の前後の関係や文脈に基づいて、単語を数値化する技術を活用していること、③文書の生成は、次に来る単語としてもっともらしいものを確率的に選ぶという作業の繰り返しによっていることであった。

その後、当研究所の機関誌「所報」6号に掲載した技術展望論文では、2024年初夏までのLLMの発展動向を詳細に解説した。上記③のような単純なアプローチでも、LLMを巨大にし、莫大な文章を学習させ、計算資源を注ぎ込めば、LLMの性能が比例的に向上し続ける現象が発見されたことや、RAGやファインチューニングなど実務への応用に向けた最新技術などを紹介した。LLMの本質的な理屈を効率的に学ぶことができる。

2024年は、生成AIの応用技術や提供サービスが大きく発展し、ビジネス活用への本格的な取り組みが始まった年であった。ChatGPTのような簡単に使える汎用Webアプリケーションが多数登場したほか、広範なリソースを検索してレポートを作成するDeep Research系のサービスや、繰り返し推論を得意とするLLMの登場、これを活用したThinking型Deep Researchの発展が進んだ[i]。

また、生成AIの民主化も急速に進展した。例えば、パブリッククラウドで生成AIサービスを開発する手法が拡張したことや、大量の計算リソースを安価に使えるようになった。このほか、ノーコード開発ツールが進化を続け、Copilotなど生成AIサービスをオフィスアプリやプログラミング環境へ取り込む動きが進んだほか、最近では、複雑なタスクを分割して複数のAIエージェントに担わせることで高度な自動処理を行う技術が注目されている。2025年は業務プロセスの再構築をAIエージェントで行う試みが活発化するといわれている。

そこで、本シリーズのその4以降では、理論からビジネスへの実装にテーマシフトし、具体的な応用例を取り上げながら生成AI技術の発展を紹介する。上記の「所報」6号では、最終節で「アプリケーション実装の学び方」を示したが、その実践編に相当する。

作ってみようPodcast

初回はPodcastの作成である。これは2つの生成AI技術の組み合わせで実装できる。一つ目は、スクリプト(原稿)の作成であり、レポートなど一定のまとまりがある文章をLLMに読み込ませ、その内容紹介や話題発展型の対談スクリプトを作成させるという技術である。

どのような対談にするかは、LLMへの指示、いわゆるプロンプトで細かく設定できる。作成言語、対談人数、話者の役割分担、カジュアル/オフィシャル、長さや構成、元レポートからの乖離度合い(忠実か発展型か)、話の解像度(大まかな紹介から緻密な議論まで)など、言葉で指示することで自在にスクリプトが作成できる。なお、その1や「所報」6号で紹介したように、生成AIは確率的生成モデルであるため、同じ指示を与えても作成物は同一とはならない。

二つ目は、完成したスクリプトを音声言語化する技術である。後者は、一般にTTS(Text-to-Speech)と呼ばれており、音声を文字起こしするSTT(Speech-to-Text)とあわせてマルチモーダル化したLLMの機能として主要LLM開発企業から提供されている。音声技術に特化したサービスをSaaSとしてWeb上で提供する企業も増えている。例えば、自分の声を一定分量学習させることで、合成された自分の声でスクリプトを読み上げさせることも可能になっており、口調や速度、トーンなども自在にコントロールできるサービスが誰でも利用可能になっている。

レポートなどのオリジナル原稿をそのままTTSで音声化すると、オーディオブック風のサービスを作成できる。オリジナル原稿が読み上げには適していない文体であった場合、前処理としてLLMに口語調に変換させるといった対応法もある。Podcastのほうが二名の掛け合いトークになるので音声化において少し工夫が必要となるが、OSS(オープンソースソフトウエア)の利用やサンプルコードを参照することで簡単に作成できる。

サンプル題材として、筆者のレポート「渡来銭と暗号通貨」(2023年6月公表、5,000文字程度)を用い、1)Webアプリで簡便に作成する方法、2)ノーコード開発ツールを使う方法、3)PythonベースのOSSを使う方法、4)PythonからLLMを動かす方法の4つを紹介する。本稿では最初の二つを取り上げ、次号で後二者を紹介する。実際に作成した事例(音声サンプルとスクリプト)は、OpenAIが3月下旬にリリースした最新のTTS(gpt-4o-mini-tts)を用いて作成したものを紹介する。

PodcastをWebアプリで

Podcastの最も簡単な作り方は、NotebookLMというWebアプリケーションの使用である。NotebookLMは、Googleが開発したAIサービスで、利用者が提供・指定する文書(ネットにある資料やサイトページのURL指定も可能)をもとに、情報の整理、要約、アイデア生成などを支援するツールである。利用者が指定した特定の情報ソースに基づいて応答を行うため、ハルシネーションを抑制した正確な回答が得られる。読み込んだ内容に関する質問をChat用のボックスから与えると、情報ソースの参照箇所を示しながら回答してくれる。この4月にはDeep Search的なネット情報検索と、結果のまとめ機能が追加されている。なお、裏で動いているLLMエンジンはGoogleのGeminiであり、2025年4月現在でGemini2.0が使用されている。

NotebookLMは、指定した情報ソースの内容をPodcast化し、音声ファイルとして提供する機能も有している。図1の右上「音声概要」にある作成ボタンをクリックすると数分で作成され、Webサイト上で試聴したり、PCなどローカル端末にダウンロードすることができる(図1では作成後にプレイボタン▷が表示されている様子を示している)[i]。

2025年4月現在では英語音声化のみに限定されている(元ソースは多言語対応)が、男女2名の対話でPodcast風のカジュアルなトークショーが生成される。スクリプト(会話原稿)の作成方針や音声化に際しての指示に関する調整機能は提供されていないが、スクリプトの内容は元のソースを的確に消化したうえで上手く構成されており、また、英語音声の質は人間の会話と区別がつかないぐらい精巧である。Podcastの対話にユーザが参加する機能も有しており、試聴を途中で止めて質問や話題などを投げかけると、これに応えてくれるという双方向型のサービスも提供されている。

NotebookLMはGoogleのアカウントさえ持っていれば(gmail使用者はメールアドレスがアカウント)、誰でもすぐに利用できる。自分の書き物が手元やネット上にあれば、それがどう英語Podcast化されるかを簡単に体験できる。

図1 NotebookLMでのPodcast作成

出所) 筆者作成。ドキュメントをアップもしくはURL指定すると、中央部にサマリーが表示され、右下の学習ガイドやブリーフィング・ドキュメントなどのボタンメニューで文章が自動作成される。中央下部には質問チャット用の入力ボックスがある。

ノーコード開発Difyでの作成

次に、生成AIサービスのノーコード開発で有名なDifyを用いてpodcastを作成した事例を紹介する。Difyは生成AI技術を活用したアプリケーションを誰でも簡単に開発・運用できるオープンソースのプラットフォームである。ノーコード(プログラムのコーディングを必要としない)またはローコード(殆んど必要としない)という簡便なツールで、AIチャットボットやタスク自動化ツール、FAQ応答システムなどを構築することができる。ChatGPTやClaude、Azure OpenAIなど、複数の大規模言語モデル(LLM)に対応しており、用途やコストに応じてモデルを選択できる。

Difyの最大の特徴は、ドラッグ&ドロップで視覚的にサービスを構築できる優れたユーザーインターフェイスである。専門知識がなくても、作業内容を言葉で指示することができるほか、情報の読み込ませ方などを簡単にセットでき、自分のニーズに合ったAIアプリケーションを直感的に構築できる。外部データベースやインターネットに接続し、情報を検索・収集し、これらをLLMに与えて作業させることも可能である。

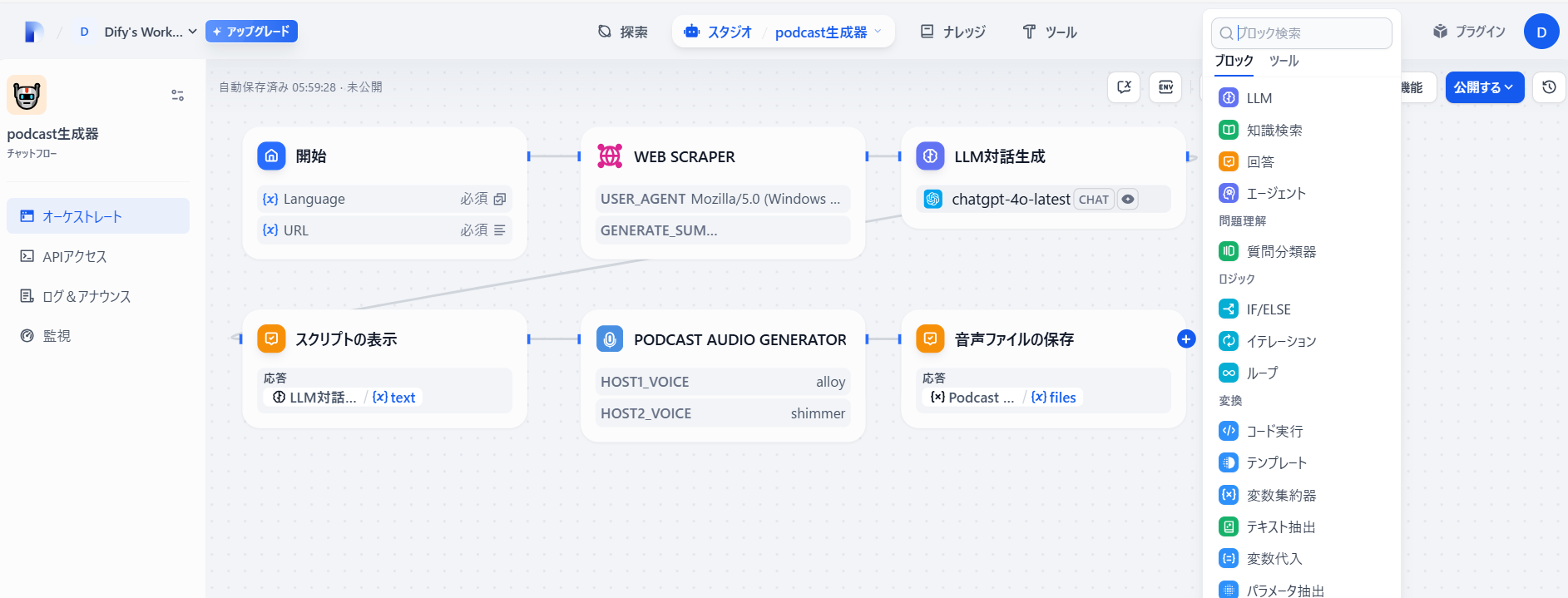

図2はDifyでpodcast作成サービスを構築した一例である。6つの作業ブロックで全体が構成されており、ブロック間のデータの受け渡しが接続線で示されている。左上の開始ブロックでは、読み込ませる文書のURLアドレスを入力するボックスと作成言語の指定ボックスを設定している。実行すると入力画面が開き、そこにPodcastの言語や、対象文書のURLを与える仕組みとなる。

次のブロックは、引き渡された指定URLのページからHTMLのタグ情報などを削除し、内容のみをスクレイピングするツールである。メニューから選択するだけで画面上に配置され、直前のブロックから受け取る情報をセットするとブロックを結ぶ線が表れる。

図2 DifyでのPodcast作成

出所) 筆者作成。左上から始まって右下で終わる作業の流れを折り返し表示でレイアウトしている。

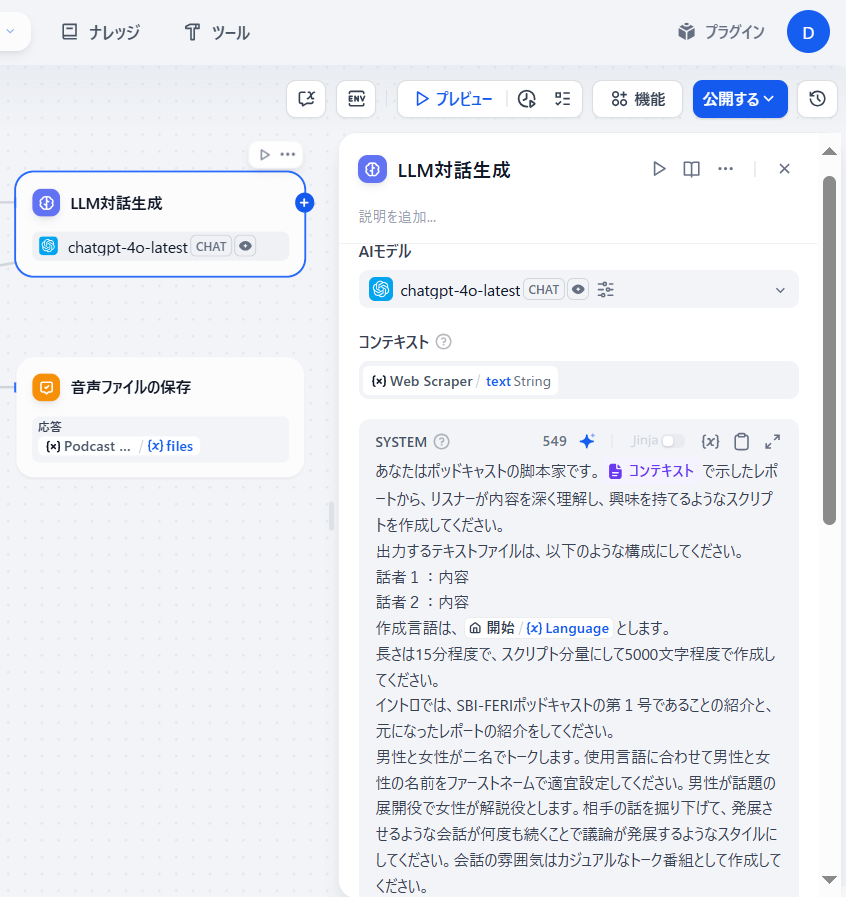

次のブロックでは整形された文書本体がLLMに引き渡される。このブロックには、Podcastをどのように作成したいのか細かい設定指示をプロンプトとしてセットする(図3)。コンピュータに対して自然言語で作業を指示できる点が生成AIの特徴の一つである。各ブロックの設定画面はブロックをクリックすると画面に現れる。

どのLLMを利用するかもここで設定する。LLMにはAPIで指示内容や読み込む文書情報が引き渡されるため、使用するLLMからAPI-keyを事前に取得し、Difyのメニュー画面で事前にセットしておく必要がある。多くのLLMは無料使用枠が設定されており、API-keyも無料で取得できる(他者に利用されないよう管理が重要である)。

図3

図3 LLMへのPodcastスクリプト作成の指示部の拡大表示

出所) 筆者作成。

図2の左下のブロックでは、右上のLLMブロックで作成された対話スクリプトをDifyのチャット画面で表示させる処理を行う。同じ内容を次のブロックに引き渡し、ここでSSTによる音声化を行う。OpenAIのtts-hd1を利用しており、複数の英語話者から男女を選択・設定している。対話スクリプトは日本語で作成しており、英語話者に日本語を音声化させているので、出来上がった音声は日本語が上手な英語母国語圏の話者風のトークとなる。漢字も正確に発音でき、対話スクリプトのうち正しく発音できなかったのは当方の名前である副島(そえじま→ふくしま)と渡来銭(とらいせん→わたらいせん)の2つのみであった。なお、本稿ではOpenAIのアカウントのみでスクリプトと音声化対応を行っているが、日本語に特化したサービスを別途利用すれば、自然な日本語での音声化が可能である。

最後のブロックでは作成された音声ファイルを受け取ってローカル端末に保存する機能が提供されている。図2では、最後のブロックの右端をクリックすると次にどのブロックを設置するか候補がリストとして表示される。いずれのブロックからでもこの機能を呼び出すことができる。図2では隠れているが「ツール」メニューからは前ブロックで利用したPodcast generatorやWeb Scraperのほか、様々なツールを呼び出すことができる。例えば、Google検索ほか各種の検索サービス、GitHubやArXivなど様々なアーカイブ、画像生成AI、クラウドのAIサービス(Amazon BedrockやAzure OpenAI)、SlackなどをDifyから利用するツールが提供されている。こうしたツールを活用することで、種々の生成AIサービスを作成することが可能となる。最後に、Difyで作成した対話スクリプトをリンク先で紹介する[i]。日英両方で作成しており、いずれもトークスタイルはカジュアルだがレポート内容をしっかり理解した会話となっていることがわかる。

次回その5では、Podcast作成の後編として、1)Apache license2.0に沿ってOSSとして提供されているPythonコードを利用して作成する方法と、2)最新のOpenAIが3月下旬に公開した最新のTTSでPodcastの音声ファイルを作成した事例を紹介する。

[i] 従来のChat系サービスはLLMが有する知識を用いて回答を返すものであった。これに対し、Deep Searchでは、質問に関する適切な情報をインターネットから検索・収集したり、複数のLLMに同じ質問を投げて回答を集め、これらの情報を集約することでより包括的で正確な回答を生成するサービスが提供される。2023年ごろに登場し始め、2024年には主要LLM開発企業が汎用型LLMに導入を進めた。特に調査研究に焦点を当てたものはDeep Researchと呼ばれる。並行してThinking系のDeep Search/Researchも発展している。こちらは、推論を得意とするLLMに、ステップを踏んだ推論や、複数の枝分かれ思考経路、推論とアクションの繰り返しなどを行わせ、回答の高品質化を図ったものである。

[ii] NotebookLMを含むGoogleサービスの利用規約についてはこちらを参照。

[iii] 3月後半期にPodcast generatorが不調となっており、4月上旬現在でも回復していない(ネット上でも同じエラーが返されることが報告されている)。このため、ここではスクリプトを紹介するにとどめた。Difyのようなノーコード開発ツールでは、提供されているツールに不具合が生じると代替選択肢がない場合、対応が困難となる。不具合の修正もツールの提供元次第である。これに対し、次回紹介するようなコードベースの開発では比較的柔軟な対応が可能となる。